Neste Tutorial do Hadoop, discutiremos os 10 melhores recursos do Hadoop. Se você não estiver familiarizado com o Apache Hadoop, consulte nossa Introdução ao Hadoop blog para obter conhecimento detalhado do framework Apache Hadoop.

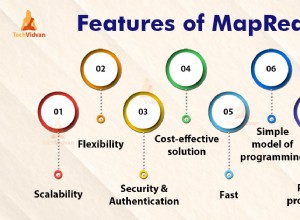

Neste blog, abordaremos os recursos mais importantes do Big Data Hadoop, como tolerância a falhas do Hadoop, processamento distribuído no Hadoop, escalabilidade, Confiabilidade, Alta disponibilidade, economia, flexibilidade, localidade de dados no Hadoop.

Introdução ao Hadoop

Hadoop é uma estrutura de software de código aberto que suporta armazenamento distribuído e processamento de uma grande quantidade de conjunto de dados. É a ferramenta de big data mais poderosa do mercado por causa de seus recursos. Recursos como tolerância a falhas, confiabilidade, alta disponibilidade etc.

Hadoop fornece-

- HDFS – Camada de armazenamento mais confiável do mundo

- MapReduce – Camada de processamento distribuído

- FIO – Camada de gerenciamento de recursos

Recursos importantes do Big Data Hadoop

Existem muitos recursos que o Apache Hadoop fornece. Vamos discutir esses recursos do Hadoop em detalhes.

a. Código aberto

É uma estrutura de programação baseada em Java de código aberto. Open source significa que está disponível gratuitamente e até podemos alterar seu código-fonte de acordo com suas necessidades.

b. Tolerância a falhas

Falhas de controle do Hadoop pelo processo de criação de réplicas. Quando o cliente armazena um arquivo no HDFS, a estrutura do Hadoop divide o arquivo em blocos. Em seguida, o cliente distribui blocos de dados em diferentes máquinas presentes no cluster HDFS.

E, em seguida, crie a réplica de cada bloco em outras máquinas presentes no cluster. O HDFS, por padrão, cria 3 cópias de um bloco em outras máquinas presentes no cluster.

Se qualquer máquina no cluster ficar inativa ou falhar devido a condições desfavoráveis. Além disso, o usuário pode acessar facilmente esses dados de outras máquinas.

c. Processamento distribuído

O Hadoop armazena uma enorme quantidade de dados de maneira distribuída no HDFS. Processe os dados em paralelo em um cluster de nós.

d. Escalabilidade

O Hadoop é uma plataforma de código aberto. Isso a torna uma plataforma extremamente escalável. Assim, novos nós podem ser facilmente adicionados sem qualquer tempo de inatividade. O Hadoop fornece escalabilidade horizontal para que um novo nó seja adicionado em tempo real ao sistema. No Apache hadoop, os aplicativos são executados em mais de milhares de node.

e. Confiabilidade

Os dados são armazenados de forma confiável no cluster de máquinas, apesar da falha da máquina devido à replicação de dados. Portanto, se algum dos nós falhar, também podemos armazenar dados de maneira confiável.

f. Alta disponibilidade

Devido a várias cópias de dados, os dados estão altamente disponíveis e acessíveis apesar da falha de hardware. Assim, qualquer máquina que desça os dados podem ser recuperados do outro caminho. Conheça o recurso de alta disponibilidade do Hadoop em detalhes.

g. Econômico

O Hadoop não é muito caro, pois é executado no cluster de hardware comum. Como estamos usando hardware de commodity de baixo custo, não precisamos gastar muito dinheiro para dimensionar seu cluster Hadoop.

eu. Flexibilidade

O Hadoop é muito flexível em termos de capacidade de lidar com todos os tipos de dados. Trata-se de estruturada, semiestruturada ou não estruturada.

j. Fácil de usar

Não há necessidade de cliente para lidar com computação distribuída, o framework cuida de todas as coisas. Portanto, é fácil de usar.

k. Localidade dos dados

Refere-se à capacidade de mover a computação para perto de onde os dados reais residem no nó. Em vez de mover dados para computação. Isso minimiza o congestionamento da rede e aumenta a taxa de transferência do sistema. Saiba mais sobre Localidade de dados.

Conclusão

Em conclusão, podemos dizer que o Hadoop é altamente tolerante a falhas. Ele armazena de forma confiável uma enorme quantidade de dados, apesar da falha de hardware. Ele fornece alta escalabilidade e alta disponibilidade.

O Hadoop é econômico, pois é executado em um cluster de hardware comum. O Hadoop trabalha na localidade de dados, pois mover a computação é mais barato do que mover dados. Todos esses recursos do Big Data Hadoop o tornam poderoso para o processamento de Big Data.