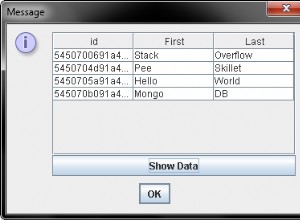

Uma maneira eficiente de escrever no mongodb a partir do pyspark é usar MongoDB Conector Spark . O Connector converterá os dados no formato BSON e os salvará no mongodb. Digamos que você tenha um dataframe spark chamado df que deseja salvar no mongodb. Podes tentar:

from pyspark.sql import SparkSession, SQLContext

from pyspark import SparkConf, SparkContext

sc = SparkContext()

spark = SparkSession(sc)

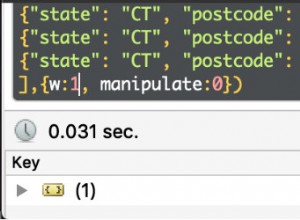

df.write.format("com.mongodb.spark.sql.DefaultSource").mode("append").option("spark.mongodb.output.uri","mongodb://username:example@sqldat.com_details:27017/db_name.collection_name?authSource=admin").save()

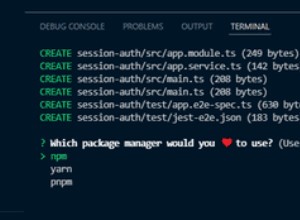

Se você estiver usando o notebook, escreva isso no topo-

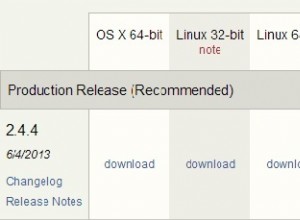

%%configure

{"conf": {"spark.jars.packages": "org.mongodb.spark:mongo-spark-connector_2.11:2.3.2"}}

Se você estiver usando o comando spark-submit:

spark-submit --conf spark.pyspark.python=/usr/bin/anaconda/envs/py35/bin/python3.5 --packages org.mongodb.spark:mongo-spark-connector_2.11:2.3.1 file_name.py