Os avanços tecnológicos trouxeram vantagens que precisam ser exploradas pelas organizações empresariais para obter o máximo valor de lucro e reduzir o custo operacional. Os dados têm sido a espinha dorsal desses avanços tecnológicos, dos quais derivam procedimentos sofisticados para atingir objetivos específicos. À medida que a tecnologia avança, há mais dados trazidos para os sistemas. Além disso, à medida que um negócio cresce, há mais dados envolvidos e a configuração do sistema de atendimento precisa ser de processamento de dados rápido, confiável no armazenamento e oferecer segurança ideal para esses dados. MongoDB é um dos sistemas que podem ser confiáveis para alcançar esses fatores.

Big Data refere-se a dados massivos que mudam rapidamente, podem ser acessados rapidamente e altamente disponíveis para atender às necessidades com eficiência. As organizações de negócios tendem a examinar as configurações de banco de dados disponíveis que forneceriam o melhor desempenho com o passar do tempo e, consequentemente, obter algum valor do Big Data.

Por exemplo, os mercados online observam os cliques na web do cliente, o poder de compra e, em seguida, usam os dados derivados para sugerir outros produtos como forma de publicidade ou usar os dados na precificação. Os robôs aprendem por meio do aprendizado de máquina e o processo obviamente envolve muitos dados coletados porque o robô teria que manter o que aprendeu na memória para uso posterior. Manter este tipo de dados complexos com software de banco de dados tradicional é considerado impraticável.

Características de Big Data

Em sistemas de software, consideramos Big Data em termos de tamanho, velocidade de acesso e tipos de dados envolvidos. Isso pode ser relativamente reduzido em 3 parâmetros:

- Volume

- Velocidade

- Variedade

Volume

O volume é o tamanho do Big Data envolvido e varia de gigabytes a terabytes ou mais. Diariamente, grandes empresas ingerem terabytes de dados de suas operações diárias. Por exemplo, uma empresa de telecomunicações gostaria de manter um registro das ligações feitas desde o início de sua operação, mensagens enviadas e quanto tempo durou cada ligação. Diariamente, há muitas dessas atividades que ocorrem, resultando em muitos dados. Os dados podem ser usados em análises estatísticas, tomada de decisões e planejamento tarifário.

Velocidade

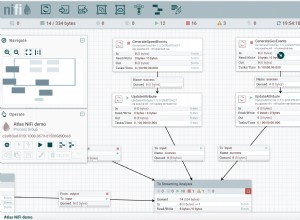

Considere plataformas como negociação Forex que precisam de atualizações em tempo real para todas as máquinas clientes conectadas e exibem novas atualizações da bolsa de valores em tempo real. Isso determina que o banco de dados de serviço deve ser bastante rápido no processamento desses dados com pouca latência em mente. Alguns jogos online envolvendo jogadores de diferentes locais do mundo coletam muitos dados de cliques, arrastamentos e outros gestos do usuário e os retransmitem entre milhões de dispositivos em microssegundos. O sistema de banco de dados envolvido precisa ser rápido o suficiente para fazer tudo isso em tempo real.

Variedade

Os dados podem ser categorizados em diferentes tipos, desde números, strings, data, objetos, arrays, dados binários, código, dados geoespaciais e expressões regulares, apenas para citar alguns. Um sistema de banco de dados ideal deve fornecer funções para aprimorar a manipulação desses dados sem incorrer em procedimentos adicionais do lado do cliente. Por exemplo, o MongoDB fornece as operações de geolocalização para uso enquanto busca locais próximos às coordenadas fornecidas na consulta. Esse recurso não pode ser alcançado com bancos de dados tradicionais, pois eles foram projetados apenas para lidar com estruturas de pequeno volume de dados, menos atualizações e algumas estruturas de dados consistentes. Além disso, serão necessárias operações adicionais para atingir algum objetivo específico, no caso de bancos de dados tradicionais.

O MongoDB também pode ser executado a partir de vários servidores, tornando-o barato e infinito, ao contrário dos bancos de dados tradicionais que são projetados apenas para serem executados em um único servidor.

Fatores a serem considerados ao escolher o MongoDB para Big Data

Big Data traz vantagem empresarial quando é altamente gerenciado por meio de poder de processamento aprimorado. Ao selecionar um sistema de banco de dados, deve-se considerar alguns fatores relacionados ao tipo de dados com os quais você estará lidando e se o sistema que você está selecionando fornece essa capacidade. Neste blog, discutiremos as vantagens que o MongoDB oferece para Big Data em comparação com o Hadoop em alguns casos.

- Uma linguagem de consulta avançada para consultas dinâmicas

- Incorporação de dados

- Alta disponibilidade

- Indexação e escalabilidade

- Motor de armazenamento eficiente e manuseio de memória

- Consistência e integridade de dados

Linguagem de consulta avançada para consultas dinâmicas

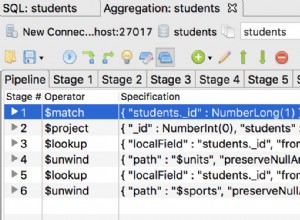

MongoDB é mais adequado para Big Data, onde os dados resultantes precisam de mais manipulações para a saída desejada. Alguns dos recursos poderosos são operações CRUD, estrutura de agregação, pesquisa de texto e o recurso Map-Reduce. Dentro da estrutura de agregação, o MongoDB possui uma funcionalidade extra de geolocalização que permite fazer muitas coisas com dados geoespaciais. Por exemplo, ao criar um índice 2Dsphere, você pode buscar locais dentro de um raio definido apenas fornecendo as coordenadas de latitude e longitude. Referindo-se ao exemplo de telecomunicações acima, a empresa pode usar o recurso Map-reduce ou a estrutura de agregação para agrupar chamadas de um determinado local, calculando o tempo médio de chamadas diariamente para seus usuários ou mais outras operações. Verifique o exemplo abaixo.

Vamos fazer uma coleta de localização com os dados

{ name: "KE",loc: { type: "Point", coordinates: [ -73.97, 40.77 ] }, category: "Parks"}

{ name: "UG",loc: { type: "Point", coordinates: [ -45.97, 40.57 ] }, category: "Parks"}

{ name: "TZ",loc: { type: "Point", coordinates: [ -73.27, 34.43 ] }, category: "Parks"}

{ name: "SA",loc: { type: "Point", coordinates: [ -67.97, 40.77 ] }, category: "Parks"}Podemos então encontrar dados para locais próximos de [-73,00, 40,00] usando a estrutura de agregação e a uma distância de 1KM com a consulta abaixo:

db.places.aggregate( [

{

$geoNear: {

near: { type: "Point", coordinates: [ -73.00, 40.00 ] },

spherical: true,

query: { category: "Parks" },

distanceField: "calcDistance",

maxDistance: 10000

}

}

]A operação Map-Reduce também está disponível no Hadoop, mas é adequada para solicitações simples. O processo iterativo para Big Data usando Map-Reduce no Hadoop é bastante lento do que no MongoDB. A razão por trás disso é que as tarefas iterativas exigem muitos processos de mapeamento e redução antes da conclusão. No processo, vários arquivos são gerados entre o mapa e reduzem as tarefas tornando-o bastante inutilizável em análises avançadas. O MongoDb introduziu o framework de pipeline de agregação para resolver esse revés e é o mais usado no passado recente.

Incorporação de dados

MongoDB é baseado em documentos com a capacidade de colocar mais campos dentro de um único campo que é denominado como incorporação. A incorporação vem com a vantagem de consultas mínimas a serem emitidas para um único documento, pois o próprio documento pode conter muitos dados. Para bancos de dados relacionais em que um pode ter muitas tabelas, você deve emitir várias consultas ao banco de dados para a mesma finalidade.

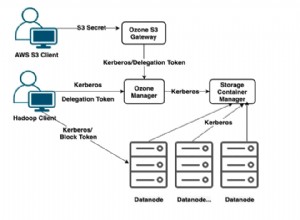

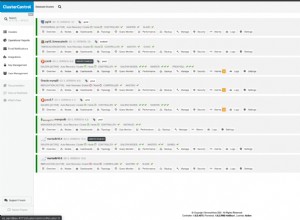

Alta disponibilidade

A replicação de dados em vários hosts e servidores agora é possível com o MongoDB, ao contrário do DBMS relacional em que a replicação é restrita a um único servidor. Isso é vantajoso porque os dados estão altamente disponíveis em diferentes locais e os usuários podem ser atendidos com eficiência pelo servidor mais próximo. Além disso, o processo de restauração ou quebra é facilmente alcançado considerando o recurso de journaling no MongoDB que cria pontos de verificação a partir dos quais o processo de restauração pode ser referenciado.

Indexação e escalabilidade

A indexação primária e secundária no MongoDB vem com muitos méritos. A indexação faz com que as consultas sejam executadas primeiro, o que é uma consideração necessária para Big Data, conforme discutimos na característica de velocidade para Big Data. A indexação também pode ser usada na criação de fragmentos. Os estilhaços podem ser definidos como subcoleções que contêm dados que foram distribuídos em grupos usando uma chave de estilhaço. Quando uma consulta é emitida, a chave de fragmentação é usada para determinar onde procurar entre os fragmentos disponíveis. Se não houvesse fragmentos, o processo levaria muito tempo para o Big Data, pois todos os documentos precisam ser examinados e o processo pode até atingir o tempo limite antes que os usuários obtenham o que desejam. Mas com o sharding, a quantidade de dados a serem buscados é reduzida e, consequentemente, reduzindo a latência de espera pelo retorno de uma consulta.

Mecanismo de armazenamento eficiente e manipulação de memória

As versões recentes do MongoDB definem o WiredTiger como o mecanismo de armazenamento padrão que possui um recurso executivo para lidar com várias cargas de trabalho. Esse mecanismo de armazenamento tem muitas vantagens para servir para Big Data, conforme descrito neste artigo. O mecanismo possui recursos como compactação, ponto de verificação e promove várias operações de gravação por meio de simultaneidade de documentos. Big Data significa muitos usuários e o recurso de simultaneidade em nível de documento permitirá que muitos usuários editem no banco de dados simultaneamente sem incorrer em nenhum revés de desempenho. MongoDB foi desenvolvido usando C++, portanto, tornando-o bom para manipulação de memória.

Consistência e integridade de dados

A ferramenta de validação JSON é outro recurso disponível no MongoDB para garantir a integridade e a consistência dos dados. Ele é usado para garantir que dados inválidos não entrem no banco de dados. Por exemplo, se houver um campo chamado age, ele sempre esperará um valor Integer. O validador JSON sempre verificará se uma string ou qualquer outro tipo de dado não foi enviado para armazenamento no banco de dados para este campo. Isso também é para garantir que todos os documentos tenham valores para este campo no mesmo tipo de dados, portanto, consistência de dados. O MongoDB também oferece recursos de backup e restauração para que, em caso de falha, seja possível voltar ao estado desejado.

Conclusão

O MongoDB lida com a análise de dados em tempo real da maneira mais eficiente, portanto, adequado para Big Data. Por exemplo, a indexação geoespacial permite uma análise de dados de GPS em tempo real.

Além da configuração básica de segurança, o MongoDB possui uma ferramenta extra de validação de dados JSON para garantir que apenas dados válidos entrem no banco de dados. Como o banco de dados é baseado em documentos e os campos foram incorporados, poucas consultas podem ser emitidas ao banco de dados para buscar muitos dados. Isso o torna ideal para uso quando se trata de Big Data.