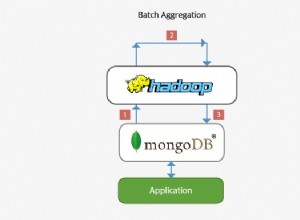

Eu descobri a resposta para a minha pergunta. Este foi um problema de compatibilidade com o conector Mongo-Spark e a versão do Spark para a qual atualizei. Especificamente, o valor findTightestCommonTypeOfTwo foi renomeado no PR:

https://github.com/apache/spark/pull/16786/files

Para o Spark 2.2.0 o conector compatível do Mongo-Spark também é 2.2.0, assim no meu exemplo, o pacote seria carregado assim:

--packages org.mongodb.spark:mongo-spark-connector_2.11:2.2.0\

Isso pode mudar no futuro, portanto, ao usar o conector, você deve verificar a compatibilidade com a versão do Spark que está sendo usada.