Uma das principais preocupações dos DBAs que precisam descarregar big data de tabelas de banco de dados muito grande (VLDB) é a velocidade. O descarregamento mais rápido torna os dados acessíveis de diferentes formas para diferentes finalidades e plataformas. Quanto mais rápido os dados são adquiridos, mais rápido eles podem ser processados e entregues. O resultado final é um tempo de solução mais rápido e, portanto, a produtividade e a competitividade das empresas que ganham dinheiro com as informações.

A maioria das ferramentas e métodos disponíveis atualmente usados para extrair dados de grandes tabelas de fatos são simplesmente muito lentos. Aqueles que pretendem ser mais rápidos são complicados, proprietários ou exigem a compra de um pacote ETL caro. Uma mudança para um paradigma ELT ou Hadoop implica em grandes despesas de hardware (ou dispositivo de banco de dados), tributa o banco de dados subjacente que está se transformando e impõe curvas de aprendizado íngremes e encargos de manutenção.

Não existem outras opções para o descarregamento e processos de downstream, que são mais rápidos, mais simples e mais acessíveis?

Por que descarregar tabelas VLDB?

Os muitos motivos pelos quais você descarregaria dados em massa dessas tabelas em primeiro lugar:

Migração de banco de dados :quanto mais rápido você conseguir dados dos bancos de dados legados, mais rápido poderá mapear e mover os dados para os novos bancos de dados. A movimentação de dados em massa seria benéfica se os volumes de dados fossem enormes, se houvesse um benefício na transformação, proteção e/ou análise off-line (que é possível de uma só vez no IRI CoSort) e quando as cargas em massa pré-classificadas forem a única maneira de atender Prazos de SLA.

Reorganização do banco de dados :Descarregue, classifique, recarregue para manter o banco de dados operando com eficiência e otimizar consultas comuns mantendo as tabelas em ordem de junção. O descarregamento é realizado em reorganizações off-line ou externas. Veja esta comparação em métodos de reorganização off-line e on-line.

Integração de dados :As operações de extração-transformação-carga (ETL) de DW em grande escala começam com a extração de tabelas na área de preparação de dados. Os dados despejados de tabelas e misturados com conjuntos de dados de mainframe, logs da web e outros arquivos simples podem ser integrados e processados com mais eficiência no sistema de arquivos. As transformações externas via não são apenas mais eficientes porque várias ações podem ser preparadas em uma única passagem de E/S, mas também porque a sobrecarga computacional de todo esse trabalho é removida do banco de dados (consulte ETL vs. ELT).

Replicação/Arquivo de Dados :Ao descarregar as tabelas de fatos, os dados operacionais de origem dourada podem ser duplicados e armazenados em um formato portátil. Os dados em arquivos simples podem ser consultados, manipulados e reformatados com ferramentas como IRI NextForm ou CoSort e usados para preencher outros bancos de dados e aplicativos. Da mesma forma, um repositório acessível desses dados também pode ser armazenado off-line para restauração e recuperação de backup ou distribuição para partes que precisam de acesso aos dados em um ambiente diferente.

Inteligência de negócios :pode ser mais rápido e fácil importar dados operacionais para o Excel e outras ferramentas de BI em formatos de arquivo simples, como CSV e XML, em vez de tentar fazer a ponte entre a tabela e uma planilha ou cubo de BI. A transferência de tabelas para arquivos simples, portanto, é uma etapa inicial e eficiente na franquia de dados – a preparação de dados para operações de BI.

Uma olhada nos métodos de descarregamento

Os métodos de extração do VLDB variam em desempenho e funcionalidade. Um bom utilitário para descarregar big data do Oracle e de outros grandes bancos de dados precisa ser eficiente, fácil de usar e oferecer suporte a certas funções de reformatação que não atrapalhariam o processo.

O comando SQL SPOOL pode despejar dados em um arquivo simples, mas normalmente é lento em volume. Utilitários nativos como exportação ou bomba de dados da Oracle são mais rápidos, mas produzem extrações proprietárias que só podem ser reimportadas para o mesmo banco de dados e não podem ser analisadas como um arquivo simples.

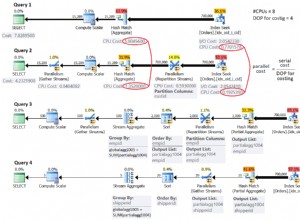

Se você precisar descarregar rapidamente tabelas grandes em arquivos simples portáteis, considere o IRI FACT (Fast Extract) para Oracle, DB2, Sybase, MySQL, SQL Server, Altibase, Tibero etc. O FACT usa paralelismo e protocolos de conexão de banco de dados nativos (como Oracle OCI ) para otimizar o desempenho da extração. O FACT GUI (assistente) gratuito que faz parte do IRI Workbench, construído no Eclipse™, apresenta tabelas e colunas disponíveis para extrair e usa a sintaxe SQL SELECT.

Outro benefício de usar o FACT é sua integração de metadados com o programa SortCL no IRI Voracity para transformar, proteger, direcionar e até mesmo relatar os extratos de arquivo simples. O FACT também cria o arquivo de controle do utilitário de carregamento em massa do banco de dados antecipando o repovoamento da mesma tabela usando arquivos simples pré-CoSorted em operações de ETL ou reorganização de grande escala.