A transformação digital é um tema quente para todos os mercados e indústrias, pois está agregando valor com taxas de crescimento explosivas. Considere que a Internet das Coisas da Indústria de Manufatura (IIOT) foi avaliada em US$ 161 bilhões com uma impressionante taxa de crescimento de 25%, o mercado de carros conectados será avaliado em US$ 225 bilhões até 2027 com uma taxa de crescimento de 17%, ou que nos primeiros três meses de Em 2020, os varejistas perceberam dez anos de penetração de vendas digitais em apenas três meses. A maior parte do que está escrito, porém, tem a ver com as plataformas de tecnologia de habilitação (nuvem ou soluções de ponta ou de ponta, como data warehouses) ou casos de uso que estão gerando esses benefícios (análise preditiva aplicada à manutenção preventiva, detecção de fraudes de instituições financeiras ou monitoramento preditivo de integridade como exemplos) não os dados subjacentes. O capítulo que falta não é sobre soluções pontuais ou a jornada de maturidade dos casos de uso. O capítulo que falta é sobre os dados – é sempre sobre os dados – e, o mais importante, os dados da jornada vão da borda ao insight da inteligência artificial.

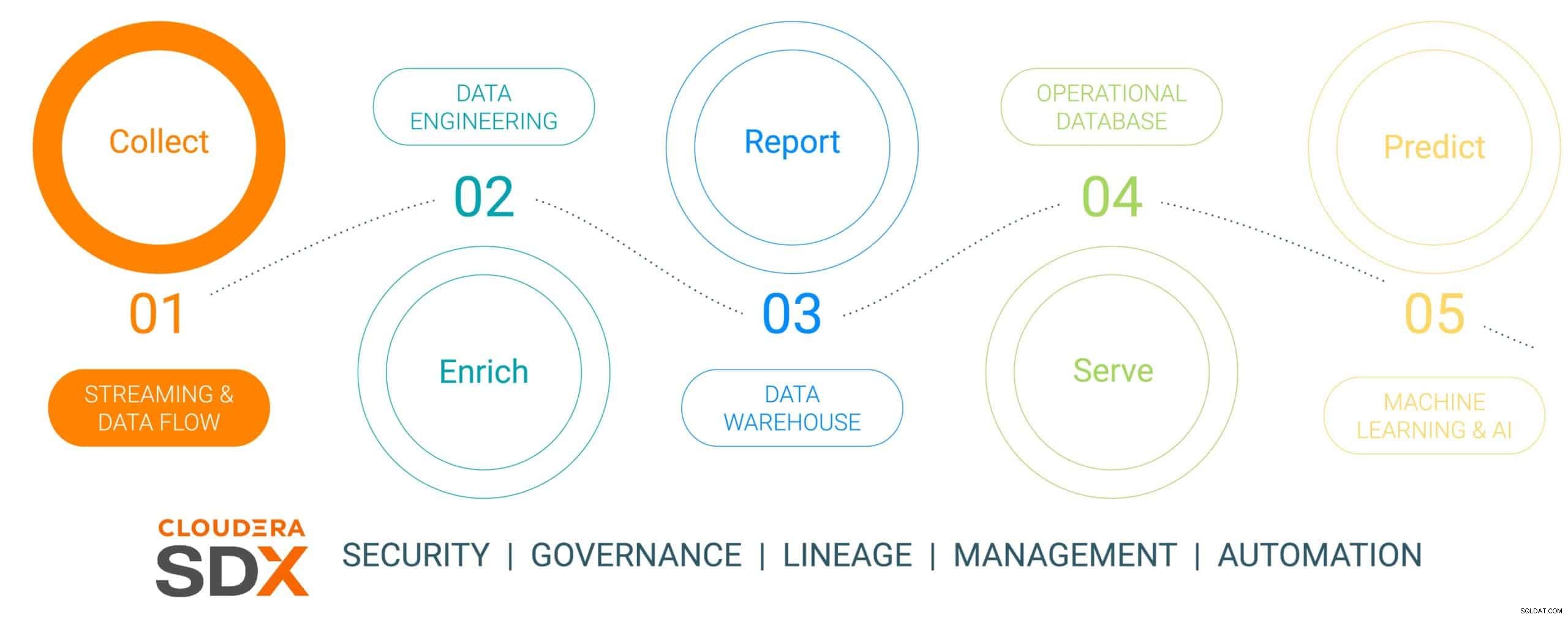

Este é o primeiro de uma série de blogs de seis partes que descreve a jornada de dados da borda à IA e os dados de valor comercial produzidos ao longo da jornada. A jornada de dados não é linear, mas é um ciclo de vida de dados de loop infinito – iniciando na borda, passando por uma plataforma de dados e resultando em insights imperativos de negócios aplicados a problemas críticos de negócios reais que resultam em novas iniciativas lideradas por dados. Simplificamos essa jornada em cinco etapas discretas com uma sexta etapa comum falando sobre segurança e governança de dados. Os seis passos são:

- Coleta de dados – ingestão de dados e monitoramento na borda (seja a borda sensores industriais ou pessoas em uma loja de varejo de tijolo e argamassa)

- Enriquecimento de dados – processamento, agregação e gerenciamento de pipeline de dados para preparar os dados para refinamento adicional

- Relatórios – fornecer insights empresariais (análise e previsão de vendas, pesquisa de mercado, orçamento como exemplos)

- Servindo – controlar e executar operações comerciais essenciais (transações em caixas eletrônicos, checkout de varejo ou monitoramento de produção)

- Análise preditiva – análise preditiva baseada em IA e aprendizado de máquina (detecção de fraudes, manutenção preditiva, otimização de inventário baseada em demanda como exemplos)

- Segurança e Governança – um conjunto integrado de tecnologias de segurança, gerenciamento e governança em todo o ciclo de vida dos dados

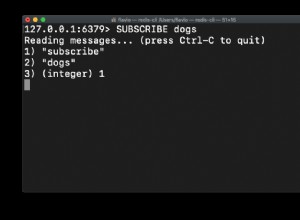

Fig 1:O Ciclo de Vida dos Dados Corporativos

Para ilustrar a jornada de dados, escolhemos um tópico de fabricação muito relevante e sustentável – fabricação de um carro elétrico, escolhido porque as operações de fabricação geralmente são de natureza revolucionária (alta maturidade digital implantando as ferramentas de dados mais atualizadas) , em comparação com o “evolucionário da velha escola” (de menor maturidade) e que a maioria desses carros é construída como plataformas de mobilidade conectada, tornando o carro mais do que apenas transporte, mas uma plataforma para conhecimento e insights baseados em dados. Esta história mostrará como os dados são coletados, enriquecidos, armazenados, servidos e usados para prever eventos no processo de fabricação do carro usando a Cloudera Data Platform.

Esta história apresentará uma empresa de fabricação de veículos elétricos simulada chamada (com um nome altamente original de) The Electric Car Company (ECC). A ECC opera várias fábricas localizadas em todo o mundo, está verticalmente integrada construindo seus próprios carros, bem como muitos dos componentes críticos, incluindo motores elétricos, baterias e peças auxiliares. Cada fábrica é encarregada de fabricar componentes diferentes, com a montagem final ocorrendo em algumas fábricas selecionadas e estrategicamente localizadas.

Desafio de coleta de dados

Gerenciar a coleta de todos os dados de todas as fábricas no processo de fabricação é uma tarefa significativa que apresenta alguns desafios:

- Dificuldade em avaliar o volume e a variedade de dados de IoT: Muitas fábricas utilizam ativos e dispositivos de fabricação modernos e legados de vários fornecedores, com vários protocolos e formatos de dados. Embora os controladores e dispositivos possam estar conectados a um sistema OT, eles geralmente não são conectados de forma que possam compartilhar facilmente os dados com sistemas de TI. Para permitir a fabricação conectada e casos de uso de IoT emergentes, a ECC precisa de uma solução que possa lidar com todos os tipos de estruturas e esquemas de dados diversos da borda, normalizar os dados e compartilhá-los com qualquer tipo de consumidor de dados, incluindo aplicativos de Big Data.

- Gerenciando a complexidade dos dados em tempo real: Para que o ECC impulsione os casos de uso de análise preditiva, uma plataforma de gerenciamento de dados precisa permitir análises em tempo real em dados de streaming. A plataforma também precisa ingerir, armazenar e processar efetivamente os dados de streaming em tempo real ou quase em tempo real para fornecer insights e ações instantaneamente.

- Liberando dados de silos independentes: Processos especializados (plataformas de inovação, QMS, MES, etc.) dentro da cadeia de valor de fabricação recompensam fontes de dados e plataformas de gerenciamento de dados diferentes que se adaptam a soluções isoladas exclusivas. Essas soluções de nicho limitam o valor da empresa, considerando apenas uma fração do insight que os dados entre empresas podem oferecer, enquanto dividem os negócios e limitam as oportunidades de colaboração. A plataforma certa deve ter a capacidade de ingerir, armazenar, gerenciar, analisar e processar dados de streaming de todos os pontos da cadeia de valor, combiná-los com fontes de historiadores de dados, ERP, MES e QMS e aproveitá-los em insights acionáveis. Esses insights fornecerão painéis, relatórios e análises preditivas que geram casos de uso de fabricação de alto valor.

- Equilibrando a borda: Entender o equilíbrio certo entre o processamento de dados na borda e na nuvem é um desafio, e é por isso que todo o ciclo de vida dos dados precisa ser considerado. Há uma tendência preocupante no setor, pois as empresas optam por se concentrar em um ou outro sem perceber que podem e devem fazer as duas coisas. A computação em nuvem tem seus benefícios para análise de longo prazo e implantação em larga escala, mas é limitada pela largura de banda e geralmente coleta grandes quantidades de dados usando apenas uma pequena parte. O valor da borda está em agir na borda onde tem o maior impacto com latência zero antes de enviar os dados mais valiosos para a nuvem para processamento adicional de alto desempenho.

Coleta de dados usando a plataforma de dados Cloudera

ETAPA 1:coletando os dados brutos

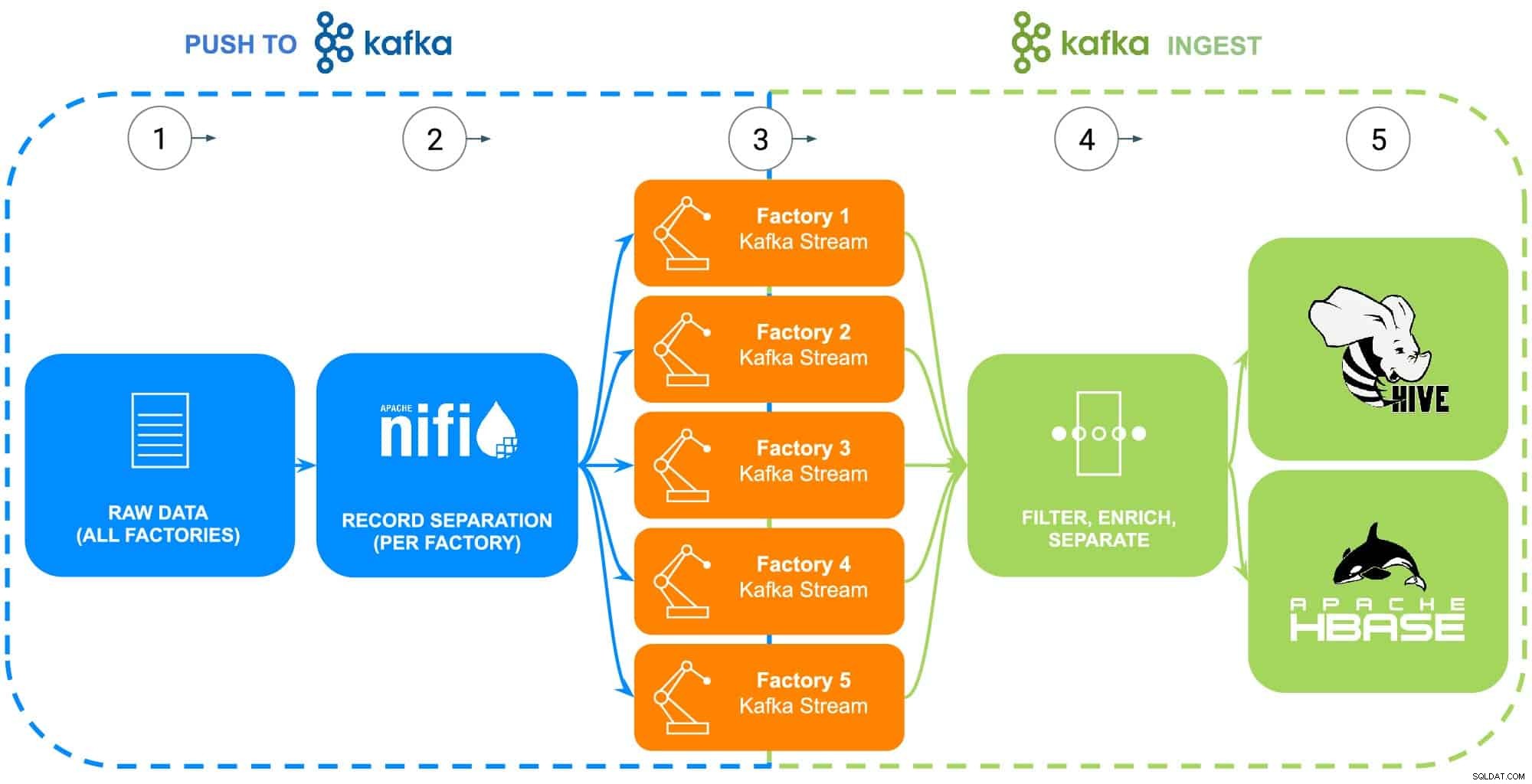

Os dados da operação de fabricação da ECC abrangem uma infinidade de fontes - robôs industriais, tanques de processo de revestimento de fosfato de corpo em branco (temperatura, concentração ou reabastecimento), telemática da cadeia de suprimentos ou informações sobre a peça principal, etc. Para este exemplo específico, a peça bruta os dados mestre para cada uma das cinco fábricas da ECC foram coletados em preparação para serem alimentados no Apache NiFi (veja a Fig. 2).

ETAPA 2:configurar fontes de dados para cada fábrica

A coleta de dados será ilustrada usando a experiência de fluxo de dados da Cloudera (alimentada pelo Apache NiFi) para recuperar esses dados brutos e dividi-los em fluxos de fábrica individuais (gerenciados pelo Apache Kafka) para se assemelhar com mais precisão a um cenário do mundo real (consulte a Fig 2). Para manter o exemplo simples, as seguintes tags de atributo de dados foram escolhidas para cada peça gerada pelas fábricas:

- ID de fábrica

- ID da máquina

- Carimbo de data e hora fabricado

- Número da peça

- Número de série

Fig 2:Diagrama de fluxo de coleta de dados.

ETAPA 3:monitore a taxa de transferência de dados de cada fábrica

Com todos os dados agora fluindo em fluxos individuais do Kafka, um arquiteto de dados está monitorando a taxa de transferência de dados de cada fábrica, bem como ajustando os recursos de computação e armazenamento necessários para garantir que cada fábrica tenha a taxa de transferência necessária para enviar dados para a plataforma.

ETAPA 4:capturar dados de streams do Apache Kafka

O Kafka captura todos os fluxos de dados de fábrica e os coleta em processadores que filtram e enriquecem para uso no controle e execução de operações comerciais essenciais alimentadas por um banco de dados operacional ou na entrega de insights empresariais por meio de um data warehouse corporativo ou usado em análises avançadas.

A ECC iniciou recentemente a produção de uma versão atualizada de seu motor elétrico que está sendo produzido apenas na Fábrica 5, esses dados serão usados como ilustração dos próximos passos no ciclo de vida dos dados

ETAPA 5:enviar dados para soluções de armazenamento

Como os engenheiros de fabricação e qualidade da ECC desejam monitorar de perto a implantação e o uso em campo desse motor, os dados de rastreabilidade de fabricação específicos são filtrados em uma rota separada e salvos em sua própria tabela no Apache Hive. Isso permitirá que os engenheiros executem consultas ad-hoc no Cloudera Data Warehouse com relação aos dados posteriormente, além de juntá-los a outros dados relevantes no data warehouse corporativo, como pedidos de reparo ou feedback do cliente para produzir casos de uso avançados, como garantia, previsão rotinas de manutenção ou entrada de desenvolvimento de produto.

Como alternativa, se desejar controlar e executar operações essenciais de negócios, todo o conjunto de dados com a adição de um carimbo de data/hora processado será enviado para o Cloudera Operational Database com Apache HBase. Esses dados servirão como base para a ECC executar sua plataforma de inventário, o que exigirá o uso de operações constantes de leitura/gravação, pois o inventário pode ser adicionado e removido milhares de vezes por dia. Como o HBase foi projetado para lidar com esses tipos de transações de dados em larga escala, ele serve como a melhor solução para esse desafio único.

Conclusão

Esta ilustração simples mostra a importância de obter a ingestão de dados correta, pois é fundamental para insights fornecidos de bancos de dados operacionais, data warehouses corporativos ou análises preditivas de machine learning analítico avançado. O valor de “fazer certo” inclui o uso de dados de qualquer fonte corporativa, quebrando os silos de dados, usando todos os dados, sejam eles de streaming ou orientados a lotes, e a capacidade de enviar esses dados para o local certo, produzindo o insight de downstream desejado.

Usando o CDP, os engenheiros de dados da ECC e outros usuários de negócios podem começar a usar os dados coletados para várias tarefas, desde gerenciamento de estoque até previsão de peças e aprendizado de máquina. Como o Cloudera Data Flow promove a ingestão de dados em tempo real de qualquer fonte corporativa, ele pode ser expandido e mantido sem amplo conhecimento de várias linguagens de programação e metodologias proprietárias de coleta de dados. Se problemas únicos forem encontrados, os engenheiros também podem criar seus próprios processos para um controle verdadeiramente refinado.

Procure o próximo blog que abordará o enriquecimento de dados e como ele suporta a história do ciclo de vida dos dados. Além disso, essa história será ampliada com demonstrações orientadas por dados, mostrando a jornada de dados em cada etapa do ciclo de vida dos dados.

Mais recursos de coleta de dados

Para ver tudo isso em ação, clique nos links relacionados abaixo para saber mais sobre Coleta de dados:

- Vídeo – Se você quiser ver e ouvir como isso foi construído, veja o vídeo no link.

- Tutoriais – Se você quiser fazer isso no seu próprio ritmo, veja um passo a passo detalhado com capturas de tela e instruções linha por linha de como configurar e executar.

- Encontro – Se você quiser falar diretamente com especialistas da Cloudera, participe de um encontro virtual para ver uma apresentação ao vivo. Haverá tempo para perguntas e respostas diretas no final.

- Usuários – Para ver mais conteúdo técnico específico para usuários, clique no link.