Recentemente, anunciamos o lançamento do ClusterControl 1.7.3, que inclui uma variedade de melhorias e recursos recém-adicionados. Um desses novos recursos é a adição de suporte no ClusterControl para permitir que um usuário configure e gerencie várias instâncias do PostgreSQL no mesmo host. Esse novo recurso é o que discutiremos em nosso blog abaixo, incluindo os motivos pelos quais esse tipo de configuração pode ajudá-lo a economizar recursos, além de fornecer instruções passo a passo sobre como obter esse tipo de instalação no ClusterControl.

Por que você precisaria de uma instalação de vários PostgreSQL em um único host?

Com o rápido desenvolvimento e aprimoramento atuais de tecnologias de hardware a software, o escopo dos requisitos tornou-se mais adaptável, flexível e escalável. Algumas organizações até preferem aproveitar a pilha de tecnologia, pois é mais fácil dimensioná-la. Além disso, há situações em que você pode querer implantar um servidor de banco de dados em um servidor avançado e poderoso que contém uma CPU grande, muita memória e dispositivos de armazenamento rápidos, poderosos e não voláteis, como SSD/Fusion IO /NVMe. Isso, no entanto, às vezes pode ser um desperdício de recursos se você estiver procurando executar os recursos compartilhados de um servidor de banco de dados (como usá-lo como escravo, máquina de backup a quente ou até mesmo como servidor de verificação de backup). Em determinadas configurações, você pode querer usar os recursos disponíveis em seu servidor poderoso como servidor de desenvolvimento e controle de qualidade para evitar custos de hardware indesejados (em vez de comprar uma máquina dedicada ou gerar uma nova instância de computação na nuvem).

Como configurar uma instalação multi-PostgreSQL

Para este exemplo, criaremos um cluster com uma instalação multi-PostgreSQL junto com instâncias multi-PostgreSQL executando em um único host usando o ClusterControl.

Nota:a partir da versão atual (ou seja, ClusterControl 1.7.3), ClusterControl não permite que você crie um cluster ou inicialize um cluster se você especificar uma informação de mestre e escravo com um PostgreSQL multiversão instalado ou com um multi -instâncias do PostgreSQL rodando em um único host. No entanto, você pode importar um nó com várias versões instaladas ou várias instâncias do PostgreSQL em execução em um único host.

Detalhes e informações do servidor

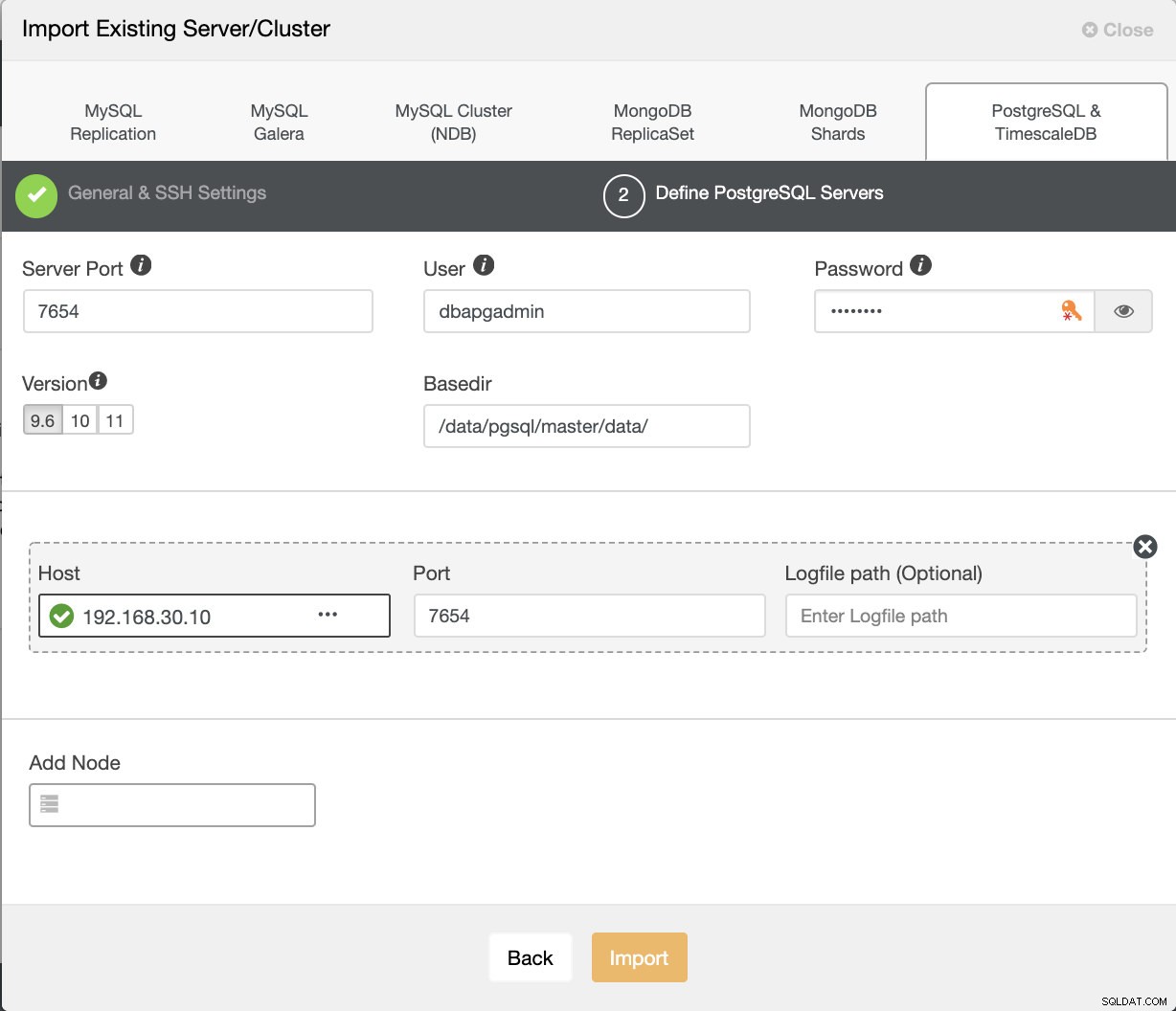

Como atualmente não podemos iniciar ou criar um cluster quando há várias versões instaladas do PostgreSQL, importaremos uma instância existente ou em execução do PostgreSQL. Abaixo estão as informações do servidor.

IP: 192.168.30.10

Usuário do SO: vagrant

tipo e versão do SO: Ubuntu 16.04.6 LTS (xenial)

e algumas informações do meu /etc/postgresql/9.6/multi_pg/postgresql.conf,

data_directory = '/data/pgsql/master/data'

hba_file = '/etc/postgresql/9.6/multi_pg/pg_hba.conf'

ident_file = '/etc/postgresql/9.6/multi_pg/pg_ident.conf'

external_pid_file = '/var/run/postgresql/9.6-main.pid'

listen_addresses = '*'

port = 7654

max_connections = 100

shared_buffers = 511995kB

work_mem = 10239kB

maintenance_work_mem = 127998kB

dynamic_shared_memory_type = posix

wal_level = hot_standby

full_page_writes = on

wal_log_hints = on

checkpoint_completion_target = 0.9

max_wal_senders = 16

wal_keep_segments = 32

hot_standby = on

effective_cache_size = 1535985kB

logging_collector = on

log_timezone = 'Etc/UTC'

cluster_name = '9.6/multi_pg'

stats_temp_directory = '/var/run/postgresql/9.6-main.pg_stat_tmp'

datestyle = 'iso, mdy'

timezone = 'Etc/UTC'

lc_messages = 'en_US.UTF-8'

lc_monetary = 'en_US.UTF-8'

lc_numeric = 'en_US.UTF-8'

lc_time = 'en_US.UTF-8'

default_text_search_config = 'pg_catalog.english'Em que uma versão existente já foi instalada:

example@sqldat.com:/home/vagrant# dpkg -l | grep 'object-relational'

ii postgresql-11 11.4-1.pgdg16.04+1 amd64 object-relational SQL database, version 11 server

ii postgresql-9.2 9.2.24-1.pgdg16.04+1 amd64 object-relational SQL database, version 9.2 server

ii postgresql-9.6 9.6.14-1.pgdg16.04+1 amd64 object-relational SQL database, version 9.6 serverAlém disso, para esta configuração, existem instâncias adicionais em execução...

example@sqldat.com:/data/pgsql/master# ps axufwww | grep 'postgre[s]'

postgres 1243 0.0 0.8 186064 17916 ? S 15:59 0:00 /usr/lib/postgresql/9.2/bin/postgres -D /var/lib/postgresql/9.2/main -c config_file=/etc/postgresql/9.2/main/postgresql.conf

postgres 1285 0.0 0.1 186064 3860 ? Ss 15:59 0:00 \_ postgres: checkpointer process

postgres 1286 0.0 0.2 186064 4620 ? Ss 15:59 0:00 \_ postgres: writer process

postgres 1287 0.0 0.1 186064 3860 ? Ss 15:59 0:00 \_ postgres: wal writer process

postgres 1288 0.0 0.2 186808 6008 ? Ss 15:59 0:00 \_ postgres: autovacuum launcher process

postgres 1289 0.0 0.1 145808 3736 ? Ss 15:59 0:00 \_ postgres: stats collector process

postgres 1246 0.0 1.2 309600 25884 ? S 15:59 0:00 /usr/lib/postgresql/11/bin/postgres -D /var/lib/postgresql/11/main -c config_file=/etc/postgresql/11/main/postgresql.conf

postgres 1279 0.0 0.1 309600 4028 ? Ss 15:59 0:00 \_ postgres: 11/main: checkpointer

postgres 1280 0.0 0.1 309600 4028 ? Ss 15:59 0:00 \_ postgres: 11/main: background writer

postgres 1281 0.0 0.4 309600 9072 ? Ss 15:59 0:00 \_ postgres: 11/main: walwriter

postgres 1282 0.0 0.3 310012 6496 ? Ss 15:59 0:00 \_ postgres: 11/main: autovacuum launcher

postgres 1283 0.0 0.1 164516 3528 ? Ss 15:59 0:00 \_ postgres: 11/main: stats collector

postgres 1284 0.0 0.3 309892 6596 ? Ss 15:59 0:00 \_ postgres: 11/main: logical replication launcher Para este exemplo, usaremos o PostgreSQL 9.6.

Construindo o cluster PostgreSQL mestre-escravo

Para criar um cluster, precisamos configurar a instância do PostgreSQL manualmente e depois importar essa instância para o ClusterControl posteriormente. Alternativamente, podemos criar um cluster com apenas um nó mestre e deixar o ClusterControl lidar com isso, mas para fazer isso precisaremos desligar todos os outros nós em execução. Isso não seria ideal se você estiver operando em servidores de banco de dados PostgreSQL ocupados.

Agora vamos fazer a configuração manual...

example@sqldat.com:/etc/postgresql/9.6/multi_pg# sudo -iu postgres /usr/lib/postgresql/9.6/bin/pg_ctl -D /data/pgsql/master/data initdb

The files belonging to this database system will be owned by user "postgres".

This user must also own the server process.

The database cluster will be initialized with locale "en_US.UTF-8".

The default database encoding has accordingly been set to "UTF8".

The default text search configuration will be set to "english".

Data page checksums are disabled.

creating directory /data/pgsql/master/data ... ok

creating subdirectories ... ok

selecting default max_connections ... 100

selecting default shared_buffers ... 128MB

selecting default timezone ... Etc/UTC

selecting dynamic shared memory implementation ... posix

creating configuration files ... ok

running bootstrap script ... ok

performing post-bootstrap initialization ... ok

syncing data to disk ... ok

WARNING: enabling "trust" authentication for local connections

You can change this by editing pg_hba.conf or using the option -A, or

--auth-local and --auth-host, the next time you run initdb.

Success. You can now start the database server using:

/usr/lib/postgresql/9.6/bin/pg_ctl -D /data/pgsql/master/data -l logfile startEm seguida, inicie o banco de dados executando o comando abaixo,

example@sqldat.com:/etc/postgresql/9.6/multi_pg# sudo -iu postgres /usr/lib/postgresql/9.6/bin/pg_ctl -D /data/pgsql/master/data -o "-c config_file=/etc/postgresql/9.6/multi_pg/postgresql.conf" -l /var/log/postgresql/postgresql-9.6-master.log start

server startingAgora, vamos verificar se a instância é executada e usa a porta desejada que usamos:

example@sqldat.com:/etc/postgresql/9.6/multi_pg# netstat -ntlvp46|grep postgres

tcp 0 0 127.0.0.1:5432 0.0.0.0:* LISTEN 1246/postgres

tcp 0 0 127.0.0.1:5433 0.0.0.0:* LISTEN 1243/postgres

tcp 0 0 0.0.0.0:7654 0.0.0.0:* LISTEN 18403/postgres

tcp6 0 0 :::7654 :::* Agora, parece correto. O pid de 18403 mostra que podemos executá-lo e tem IPv4 e IPv6 abertos.

Agora, vamos importar isso para o ClusterControl. Vá para Implantar → Importar servidor/banco de dados existente , para importar o nó mestre desejado que acabamos de configurar.

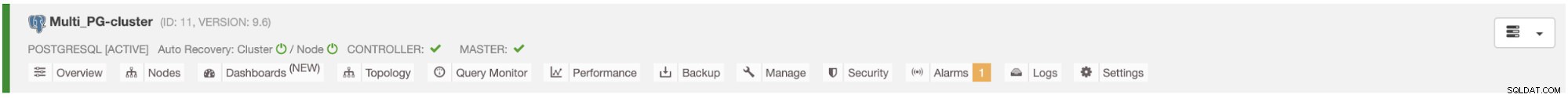

Depois de clicar no botão Importar, você poderá ter um cluster com um nó mestre como abaixo:

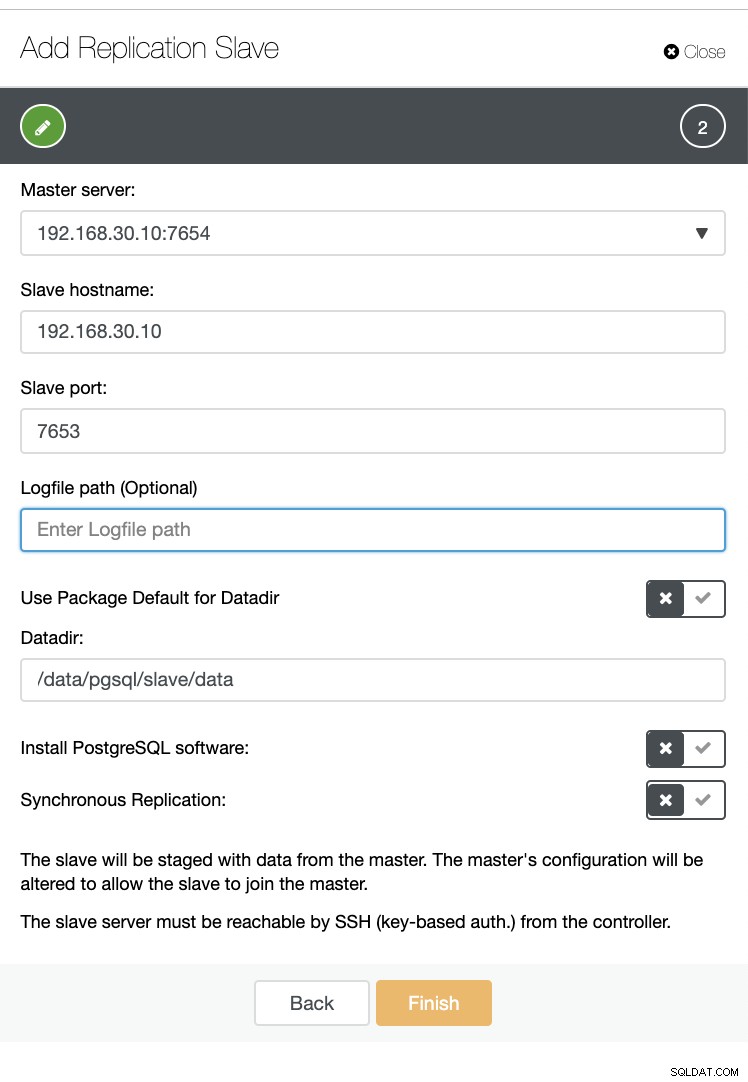

Agora, vamos criar um escravo dentro do mesmo host (ou seja, com IP 192.168.30.10).

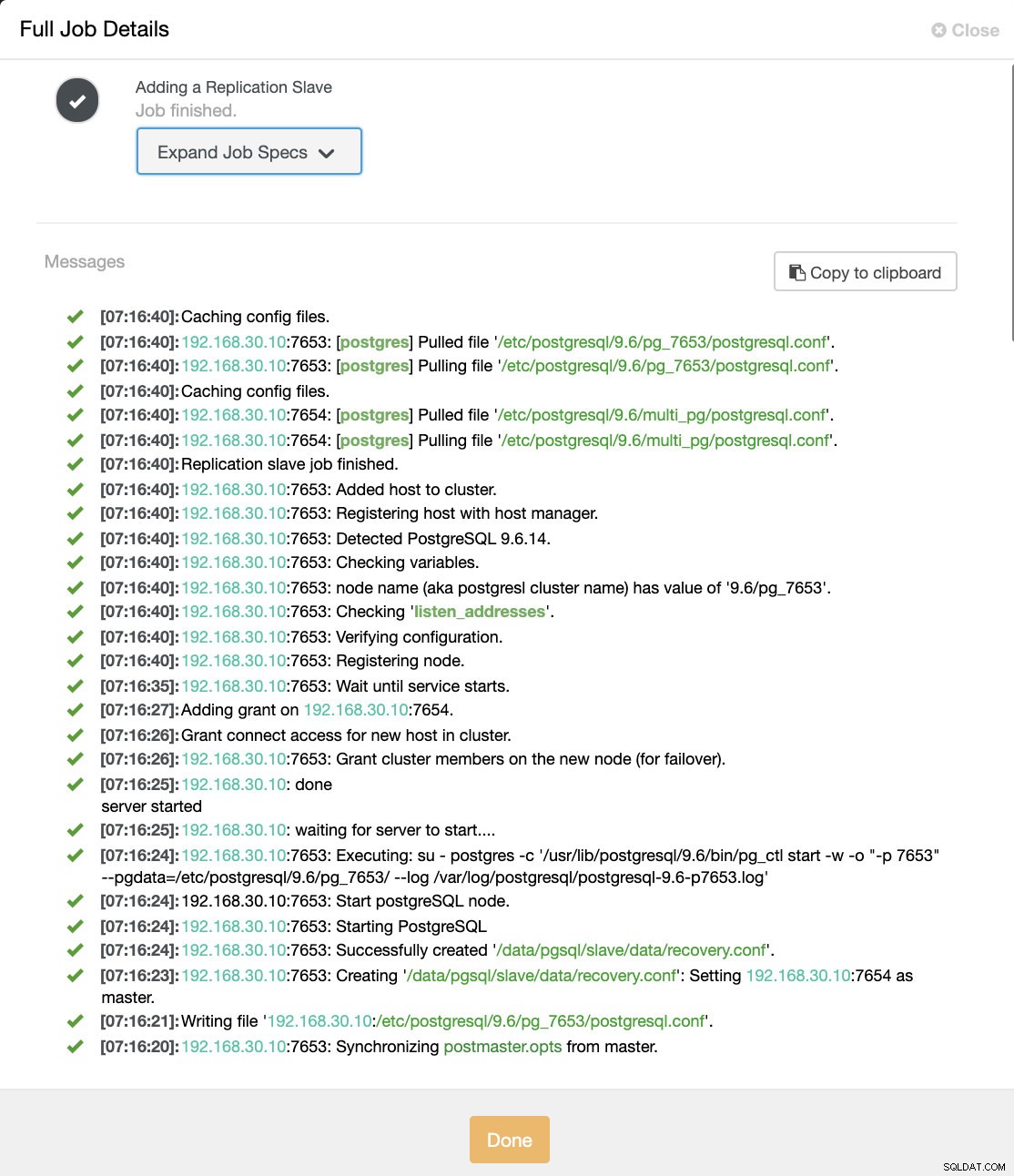

E não se preocupe, o ClusterControl cuidará disso para você, como mostra um exemplo de log de atividades de trabalho abaixo.

Você pode ver que ele foi configurado e instalado com sucesso. Tecnicamente, o ClusterControl criará um diretório em /etc/postgresql/

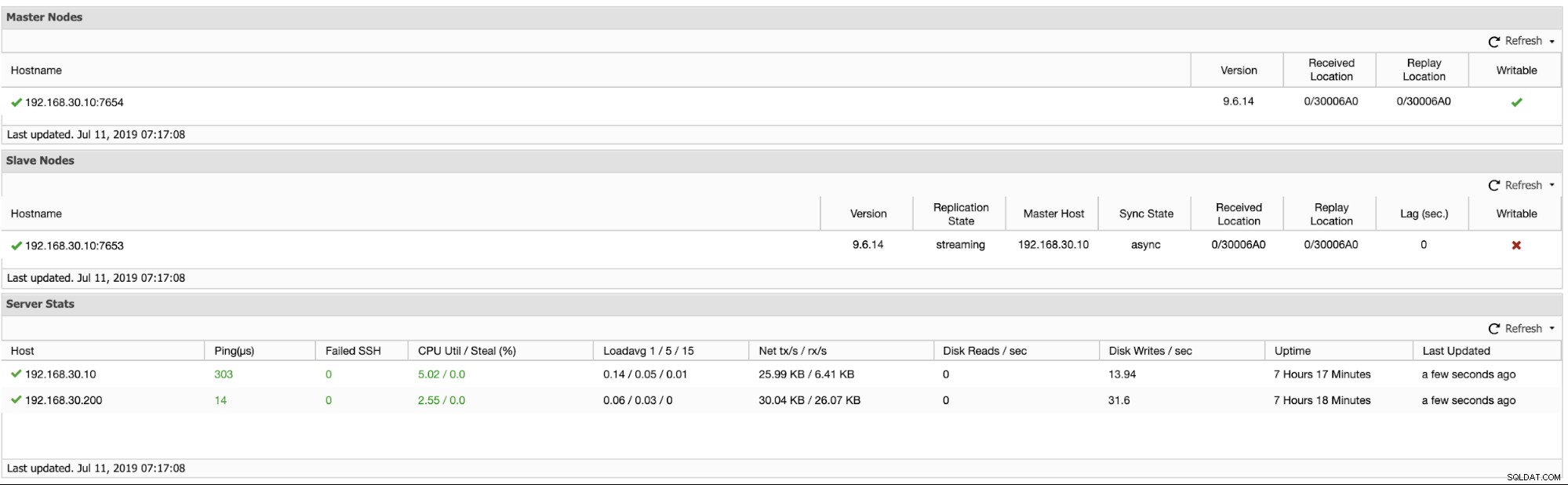

Agora vamos confirmar com pg_lsclusters e veja se a instância multi-PostgreSQL está sendo executada em paralelo em um host. Ver abaixo:

example@sqldat.com:/var/log/postgresql# pg_lsclusters

Ver Cluster Port Status Owner Data directory Log file

9.2 main 5433 online postgres /var/lib/postgresql/9.2/main /var/log/postgresql/postgresql-9.2-main.log

9.6 multi_pg 7654 online postgres /data/pgsql/master/data /var/log/postgresql/postgresql-9.6-master.log

9.6 pg_7653 7653 online,recovery postgres /data/pgsql/slave/data pg_log/postgresql-%Y-%m-%d_%H%M%S.log

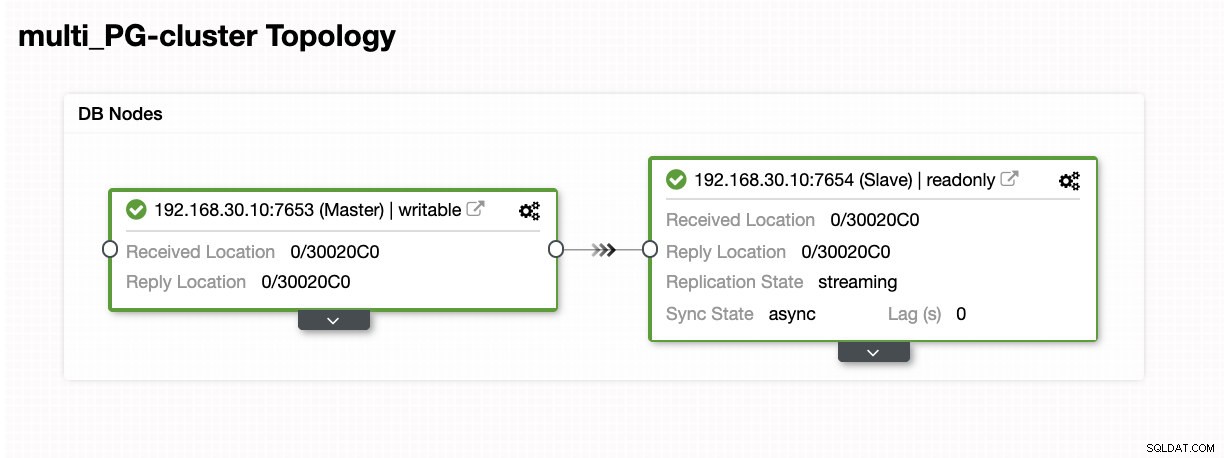

11 main 5432 online postgres /var/lib/postgresql/11/main /var/log/postgresql/postgresql-11-main.logAlém disso, as métricas quanto aos clusters de replicação lógica são vistas abaixo:

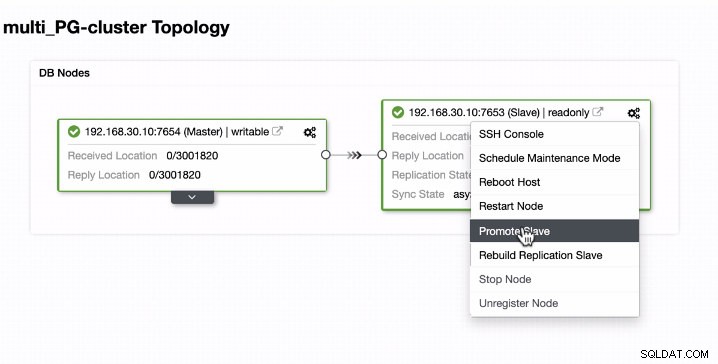

Promovendo o escravo em um Multi-PostgreSQL executando instâncias em um único host

A promoção de escravos é fácil para instâncias multi-PostgreSQL em execução em um único host. Como você pode ver abaixo, esse tipo de ambiente funciona perfeitamente quando manipulado pelo ClusterControl.

Agora, vamos ver o que acontece em segundo plano enquanto o ClusterControl promove o escravo. Veja a especificação e os detalhes completos do trabalho

[09:01:02]:Successfully promoted a new master.

[09:01:02]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: promote finished (this is the new master).

[09:01:02]:Servers after promote:

<em style='color: #1abc9c;'>192.168.30.10</em>:7653:

• Role: master (slaves: 1)

• Status: CmonHostOnline (NODE_CONNECTED)

• Receive/replay: 0/30020C0; 0/30020C0

<em style='color: #1abc9c;'>192.168.30.10</em>:7654:

• Role: slave (slaves: 0)

• Status: CmonHostOnline (NODE_CONNECTED)

• Receive/replay: 0/30020C0; 0/30020C0

• Master: 192.168.30.10:7653

[09:01:02]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Restarted with new master.

[09:01:02]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Started PostgreSQL.

[09:00:53]:<em style='color: #1abc9c;'>192.168.30.10</em>: done

server started

[09:00:53]:<em style='color: #1abc9c;'>192.168.30.10</em>: waiting for server to start....

[09:00:52]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Executing: su - postgres -c '/usr/lib/postgresql/9.6/bin/pg_ctl start -w -o "-p 7654" --pgdata=/etc/postgresql/9.6/multi_pg/ --log /var/log/postgresql/postgresql-11-main.log'

[09:00:51]:192.168.30.10:7654: Start postgreSQL node.

[09:00:51]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Starting PostgreSQL.

[09:00:51]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Successfully created '<em style='color: #109602;'>/data/pgsql/master/data/recovery.conf</em>'.

[09:00:50]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Creating '<em style='color: #109602;'>/data/pgsql/master/data/recovery.conf</em>': Setting <em style='color: #1abc9c;'>192.168.30.10</em>:7653 as master.

[09:00:50]:<em style='color: #1abc9c;'>192.168.30.10</em>: servers diverged at WAL position 0/3001890 on timeline 1

no rewind required

[09:00:49]:Running /usr/lib/postgresql/9.6/bin/pg_rewind --target-pgdata=/data/pgsql/master/data --source-server="host=192.168.30.10 port=7653 user=dbapgadmin password=***** dbname=postgres"

[09:00:47]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: Granting host (<em style='color: #1abc9c;'>192.168.30.10</em>:7654).

[09:00:45]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Stopped PostgreSQL.

[09:00:38]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Waiting to stop.

[09:00:38]:192.168.30.10:7654: node is already stopped. No need to stop it.

[09:00:38]:192.168.30.10:7654: Stop postgreSQL node.

[09:00:38]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Stopping PostgreSQL.

[09:00:38]:Switching slaves to the new master.

[09:00:38]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: Became master, ok.

[09:00:37]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: Waiting to become a master.

[09:00:37]:<em style='color: #1abc9c;'>192.168.30.10</em>: server promoting

[09:00:36]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: Attempting to promote using <strong style='color: #59a449;'>pg_ctl</strong>.

[09:00:36]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: Promoting host.

[09:00:35]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Stopped PostgreSQL.

[09:00:28]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Waiting to stop.

[09:00:28]:<em style='color: #1abc9c;'>192.168.30.10</em>: done

server stopped

[09:00:28]:<em style='color: #1abc9c;'>192.168.30.10</em>: waiting for server to shut down....

[09:00:27]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Executing: su - postgres -c '/usr/lib/postgresql/9.6/bin/pg_ctl stop --pgdata=/etc/postgresql/9.6/multi_pg/'

[09:00:26]:192.168.30.10:7654: Stop postgreSQL node.

[09:00:26]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Stopping PostgreSQL.

[09:00:26]:<em style='color: #1abc9c;'>192.168.30.10</em>:7654: Stopping the current master.

[09:00:26]:Switching over to <em style='color: #1abc9c;'>192.168.30.10</em>:7653 (previous master is <em style='color: #1abc9c;'>192.168.30.10</em>:7654)

[09:00:26]:Servers:

<em style='color: #1abc9c;'>192.168.30.10</em>:7653:

• Role: slave (slaves: 0)

• Status: CmonHostOnline (NODE_CONNECTED)

• Receive/replay: 0/3001820; 0/3001820

• Master: 192.168.30.10:7654

<em style='color: #1abc9c;'>192.168.30.10</em>:7654:

• Role: master (slaves: 1)

• Status: CmonHostOnline (NODE_CONNECTED)

• Receive/replay: 0/3001820; 0/3001820

[09:00:26]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: Current master is <em style='color: #1abc9c;'>192.168.30.10</em>:7654.

[09:00:26]:<em style='color: #1abc9c;'>192.168.30.10</em>:7653: Promoting server to master.

Job spec: {

"command": "promote_replication_slave",

"group_id": 1,

"group_name": "admins",

"job_data":

{

"clusterId": "6",

"slave_address": "192.168.30.10:7653"

},

"user_id": 1,

"user_name": "example@sqldat.com"

}Como você vê, foi tratado sem problemas, mesmo no mesmo host. O resultado da topologia mostra que ela foi promovida com sucesso.

Conclusão

Estamos empolgados com o lançamento do ClusterControl 1.7.3, achamos que ele tem muito a oferecer. Também achamos que essas novas instâncias Multi-PostgreSQL executadas no mesmo recurso de host são outro grande passo para melhorar nosso suporte geral ao PostgreSQL. Experimente e deixe-nos saber quais são seus pensamentos abaixo sobre este novo recurso.